Le dernier rapport du GRIT montre clairement une chose : notre secteur fait face à une crise de confiance. La « qualité des échantillons et des données » s'est hissée au premier rang des besoins non satisfaits, ce qui reflète ce que de nombreux chercheurs savent déjà : trop souvent, les données sur lesquelles nous nous appuyons ne sont pas aussi fiables qu'elles devraient l'être. La pression pour fournir des informations plus rapidement et à moindre coût a poussé les méthodes traditionnelles à la limite, et l'augmentation des réponses générées par l'IA et la fraude des participants n'ont fait que creuser les failles. Il en résulte un sentiment croissant d'incertitude quant à quoi et à qui faire confiance.

À la base, il ne s'agit pas d'un problème technologique, mais d'un problème relationnel. Pendant des années, l'industrie a traité les participants comme des transactions plutôt que comme des partenaires, privilégiant l'efficacité à l'authenticité lorsqu'il s'agit de nouer des relations avec eux et de nouer des relations avec eux. À cela s'ajoute l'afflux de personnes interrogées frauduleuses qui s'infiltrent dans les sources de recrutement, ce qui rend plus difficile que jamais de savoir s'il s'agit de véritables participants ou d'opportunistes qui utilisent le système pour obtenir des incitations. Le résultat est prévisible : des participants désengagés ou non authentiques, des données douteuses et une érosion de la confiance dans ce que la recherche peut réellement apporter. Lorsque « suffisamment proche » devient « suffisant », tout le monde est perdant : le chercheur, le client et, en fin de compte, le consommateur dont nous prétendons représenter la voix.

Pour rétablir la confiance, il ne suffit pas d'améliorer la détection des fraudes ou de renforcer les contrôles. Cela exige de repenser la façon dont nous trouvons les gens et communiquons avec eux, et c'est là que la technologie peut nous aider à mieux le faire. L'avenir de la qualité réside dans les plateformes qui allient connexion humaine et automatisation intelligente. La technologie nous permet désormais d'aller au-delà des interactions ponctuelles et de créer des environnements permanents où les participants se sentent vus, valorisés et responsables. Les communautés de recherche sont à la pointe de cette évolution en proposant des espaces où l'engagement est soutenu, les commentaires sont contextuels et la qualité est vérifiée en temps réel, et non pas au hasard.

Dans ces environnements, les chercheurs peuvent cultiver une participation et des relations authentiques. Ils peuvent profiler et suivre les individus de manière longitudinale, observer les changements de comportement au fil du temps et valider les résultats sur plusieurs points de contact. Il en résulte non seulement des données plus propres, mais aussi une meilleure compréhension des personnes et des motivations qui les sous-tendent. Dans un monde inondé de bruit, ce niveau de connexion est ce qui distingue les informations significatives des découvertes superficielles.

Ce n'est un secret pour personne que l'IA joue un rôle majeur dans cette transformation. Lorsqu'il est intégré au processus de recherche, il aide les chercheurs à identifier des modèles, à détecter les fraudes et à valider l'authenticité plus rapidement et plus précisément que jamais. Il agit comme un assistant : il rationalise les flux de travail, permet de gagner du temps et de faire ressortir les nuances qui pourraient autrement passer inaperçues. Utilisée de manière responsable, l'IA élève le jugement humain au lieu de le remplacer, aidant ainsi les chercheurs à réaliser ce qui serait presque impossible à réaliser manuellement à une échelle significative tout en conservant les nuances et la profondeur qui caractérisent un travail de qualité exceptionnel. La clé est la transparence : utiliser l'IA comme collaborateur pour renforcer la confiance dans chaque réponse collectée.

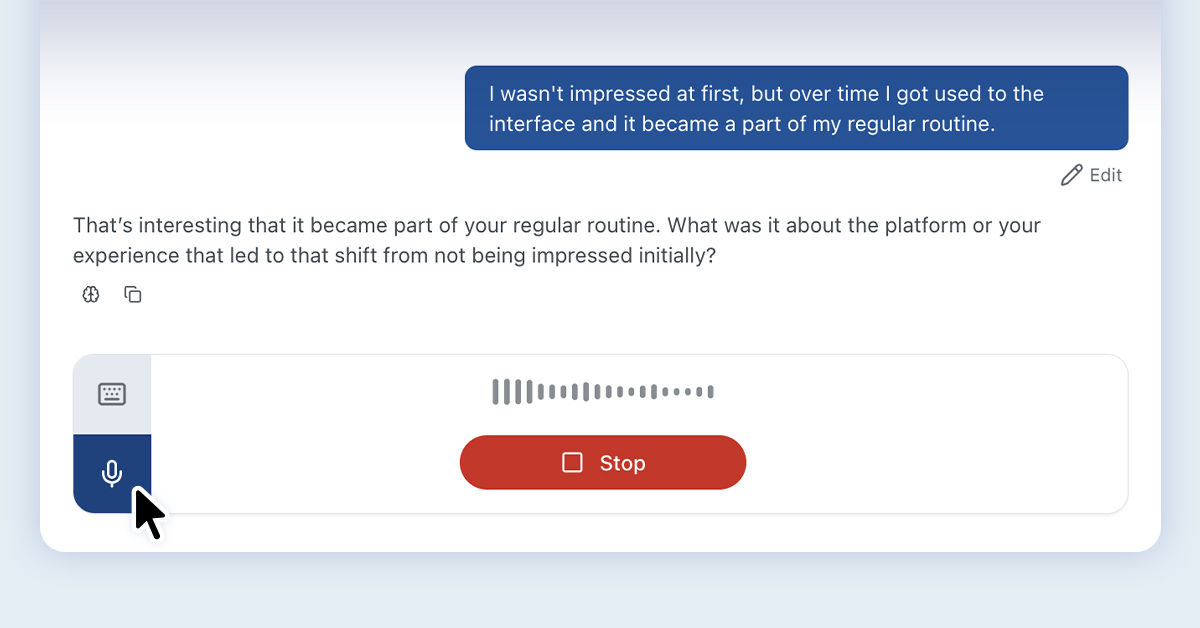

Chez Recollective, nous avons mis en place des mesures de protection qui donnent aux chercheurs confiance dans la qualité de leurs participants et de leurs données. Notre plateforme inclut des contrôles de qualité tout au long du parcours des participants, allant du filtrage par vidéo au suivi du temps consacré aux tâches, en passant par des outils de prévention des fraudes qui bloquent les réponses copier-coller et signalent les comportements inauthentiques. Les chercheurs peuvent mettre en évidence, évaluer et suivre les participants au fil du temps, établissant ainsi un bilan des performances qui renforce la confiance et la responsabilité. Notre Type de tâche d'IA conversationnelle agit comme une garantie de qualité en temps réel, en détectant les réponses hors sujet ou mal alignées et en demandant automatiquement une correction de trajectoire pour préserver l'intégrité des données.

En utilisant une technologie telle que Recollective, qui associe un engagement continu à une automatisation intelligente, les chercheurs peuvent s'assurer qu'ils s'adressent aux bonnes personnes, collectent des réponses authentiques et fournissent des informations en toute confiance. Ces relations de confiance restaurent à la fois l'intégrité de nos données et la crédibilité de notre discipline.

Les résultats du GRIT nous rappellent que les principaux besoins non satisfaits (budget, temps et qualité) sont tous liés. La technologie n'est pas l'ennemie de la confiance ; c'est le pont qui permet de la reconstruire et l'avenir de la perspicacité n'est pas « suffisant » : il est plus intelligent, plus rapide et plus humain que jamais.

.svg)